Попадая на курсы по SEO-продвижению, новички встречаются с большим количеством понятных и не очень терминов. Во всем этом разобраться не так уже и просто, особенно если изначально плохо объяснили или упустили какой-то из моментов. Рассмотрим значение в файле robots.txt Disallow, для чего нужен этот документ, как его создать и работать с ним.

Простыми словами

Чтобы не «кормить» читателя сложными объяснениями, которые обычно встречаются на специализированных сайтах, лучше объяснить все «на пальцах». Поисковый робот приходит на ваш сайт и индексирует страницы. После вы смотрите отчеты, которые указывают на проблемы, ошибки и пр.

Но на сайтах есть и такая информация, которая не обязательна для статистики. К примеру, страница «О компании» или «Контакты». Все это необязательно для индексации, а в некоторых случаях нежелательно, поскольку может исказить статистические данные. Чтобы этого всего не было, лучше закрывать эти страницы от робота. Именно для этого и нужна команда в файле robots.txt Disallow.

Стандарт

Этот документ всегда есть на сайтах. Его созданием занимаются разработчики и программисты. Иногда это делать могут и владельцы ресурса, особенно, если он небольшой. В этом случае работа с ним не занимает много времени.

Robots.txt называют стандартом исключений для поискового робота. Он представлен документом, в котором прописывают основные ограничения. Документ помещают в корень ресурса. При этом так, чтобы его можно было найти по пути «/robots.txt». Если у ресурса есть несколько поддоменов, то этот файлик помещается в корень каждого из них. Стандарт непрерывно связан с другим – Sitemaps.

Карта сайта

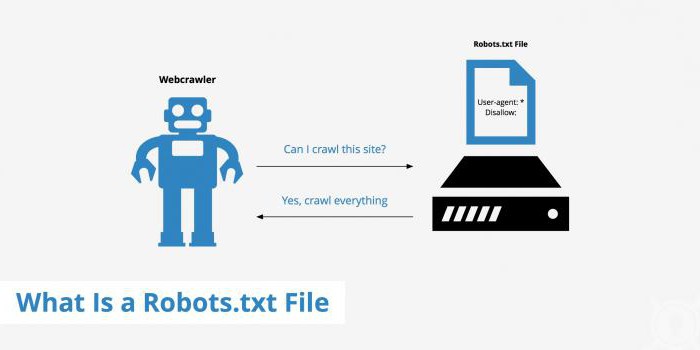

Чтобы понимать полную картину того, о чем идет речь, пару слов о Sitemaps. Это файл написанный языком XML. Он хранит все данные о ресурсе для ПС. По документу можно узнать о веб-страницах, индексируемых роботами.

Файл дает быстрый доступ ПС к любой страничке, показывает последние изменения, частоту и важность их. По этим критериям робот наиболее правильно сканирует сайт. Но важно понимать, что наличие такого файла не дает уверенности в том, что все странички будут проиндексированы. Он является больше подсказкой на пути к этому процессу.

Использование

Правильный файл robots.txt используется добровольно. Сам стандарт появился еще в 1994 году. Его принял консорциум W3C. С того момента стал использоваться почти во всех поисковых машин. Он нужен для «дозированной» корректировки сканирования ресурса поисковым роботом. Файл содержит комплекс инструкций, которые используют ПС.

Благодаря набору инструментов легко устанавливают файлы, страницы, каталоги, которые нельзя индексировать. Robots.txt указывает и на такие файлы, которые нужно проверить сразу.

Для чего?

Несмотря на то, что файл действительно можно использовать добровольно, его создают практически все сайты. Это нужно для того, чтобы упорядочить работу робота. Иначе он будет проверять все страницы в случайной последовательности, и помимо того, что может пропускать некоторые страницы, создает весомую нагрузку на ресурс.

Также файл используют, чтобы скрыть от глаз поисковой системы:

- Страницы с личными данными посетителей.

- Страницы, на которых есть формы отправки данных и т. п.

- Сайты-зеркала.

- Страницы с результатами поиска.

Если вы указали в robots.txt Disallow для конкретной страницы, есть шанс, что она все же появится в поисковой выдаче. Такой вариант может произойти, если на одном из внешних ресурсов или внутри вашего сайта размещена ссылка на такую страницу.

Директивы

Говоря о запрете для поисковой системы, часто используют понятие «директивы». Этот термин известен всем программистам. Он часто заменяется синонимом «указание» и используется вместе с «командами». Иногда может быть представлен набором конструкций языка программирования.

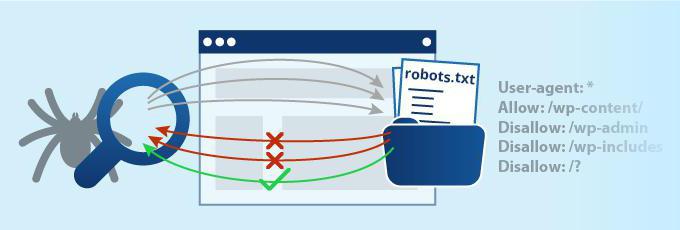

Директива Disallow в robots.txt одна из самых распространенных, но не единственная. Помимо неё есть еще несколько, которые отвечают за определенные указания. К примеру, есть User agent, который показывает на роботов поисковой системы. Allow - это противоположная команда Disallow. Она указывает на разрешение для сканирования некоторых страниц. Далее рассмотрим подробнее основные команды.

Визитка

Естественно, в файле robots.txt User agent Disallow не единственные директивы, но одни из самых распространенных. Именно из них состоит большинство файлов для небольших ресурсов. Визиткой для любой системы все же считается команда User agent. Это правило создано для того, чтобы указать на роботов, посматривающих инструкции, которые будут написаны далее в документе.

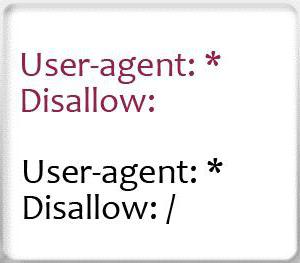

Сейчас существует 300 поисковых роботов. Если вы хотите, чтобы каждый из них следовал определенным указанием, не следует их переписывать все вряд. Достаточно будет указать «User-agent: *». «Звездочка» в этом случае покажет системам, что следующие правила рассчитаны на всех поисковые системы.

Если же вы создаете указания для Google, тогда нужно указать имя робота. В этом случае используйте Googlebot. Если в документе будет указано только это имя, тогда остальные поисковые системы не будут воспринимать команды файла robots.txt: Disallow, Allow и т. д. Они будут считать, что документ пустой, и для них нет никаких инструкций.

Полный список имен ботов можно найти в интернете. Он очень длинный, поэтому, если вам нужны указания для определенных сервисов Google или Yandex, придется указывать конкретные имена.

Запрет

О следующей команде мы уже говорили много раз. Disallow как раз и указывает на то, какая информация не должна считываться роботом. Если вы хотите показать поисковым системам весь свой контент, тогда достаточно написать «Disallow:». Так роботы будут сканировать все страницы вашего ресурса.

Полный запрет индексации в robots.txt «Disallow: /». Если вы напишите так, тогда роботы не будут сканировать ресурс вообще. Обычно это делается на начальных этапах, при подготовке к запуску проекта, экспериментах и т. д. Если сайт уже готов показать себя, тогда смените это значение, чтобы пользователи могли познакомиться с ним.

Вообще команда универсальная. Она может заблокировать определенные элементы. К примеру, папку, командой «Disallow: /papka/», может запретить для сканирования ссылку, файл или документы определенного разрешения.

Разрешение

Чтобы позволить роботу просматривать определенные страницы, файлы или каталоги, используют директиву Allow. Иногда команда нужна для того, чтобы робот посетил файлы с определенного раздела. К примеру, если это интернет-магазин, можно указать каталог. Остальные страницы не будут просканированы. Но помните, что для начала нужно запретить сайту просматривать весь контент, а после указать команду Allow с открытыми страницами.

Зеркала

Еще одна директива Host. Её используют не все веб-мастера. Она нужна в том случае, если ваш ресурс имеет зеркала. Тогда это правило обязательное, поскольку указывает роботу "Яндекса" на то, какое из зеркал является главным, и какое нужно сканировать.

Система не сбивается самостоятельно и легко находит нужный ресурс по инструкциям, которые описаны в robots.txt. В файлике сам сайт прописывается без указания «http://», но только в том случае, если он работает на HTTP. Если же он использует протокол HTTPS, тогда указывает эту приставку. Например, «Host: site.com» если HTTP, или «Host: https://site.com» в случае с HTTPS.

Навигатор

О Sitemap мы уже говорили, но как об отдельном файле. Глядя на правила написания robots.txt с примерами, видим и использование подобной команды. В файле указывают «Sitemap: http://site.com/sitemap.xml». Это делается для того, чтобы робот проверил все страницы, которые указаны на карте сайта по адресу. Каждый раз возвращаясь, робот будет просматривать новые обновления, изменения, которые были внесены и быстрее отправлять данные в поисковую систему.

Дополнительные команды

Это были основные директивы, которые указывают на важные и нужные команды. Есть и менее полезные, и не всегда применяемые указания. К примеру, Crawl-delay задает период, который будет использоваться между загрузками страниц. Это нужно для слабых серверов, чтобы не «положить» их нашествием роботов. Для указания параметра используются секунды.

Clean-param помогает избежать дублирование контента, который находится на разных динамических адресах. Они возникают в том случае, если существует функция сортировки. Такая команда будет выглядеть так: «Clean-param: ref /catalog/get_product.com».

Универсальный

Если вы не знаете, как создать правильный robots.txt, – не страшно. Помимо указаний, есть универсальные варианты этого файла. Их можно размещать практически на любом сайте. Исключением может стать только крупный ресурс. Но в этом случае о файле должны знать профессионалы и заниматься им специальные люди.

Универсальный набор директив позволяет открывать содержимое сайта для индексации. Тут есть прописка хоста и указывается карта сайта. Она дает возможность роботам всегда посещать страницы, обязательные для сканирования.

Загвоздка в том, что данные могут варьироваться в зависимости от системы, на которой стоит ваш ресурс. Поэтому правила нужно подбирать, глядя на тип сайта и CMS. Если вы не уверены, что созданный вами файл правильный, можно проверить в инструменте вебмастера Google и "Яндекс".

Ошибки

Если вы понимаете, что значит Disallow в robots.txt, это не дает гарантии того, что вы не ошибетесь при создании документа. Существует ряд распространенных проблем, которые возникают у неопытных пользователей.

Часто путают значения директивы. Это может быть связано и с непониманием, и с незнанием указаний. Возможно, пользователь просто недоглядел и по невнимательности перепутал. К примеру, могут использовать для User-agent значение «/», а для Disallow имя робота.

Перечисление – это еще одна распространенная ошибка. Некоторые пользователи считают, что перечисление запрещенных страниц, файлов или папок нужно указывать подряд в один ряд. На деле же для каждой запрещенной или разрешенной ссылки, файла и папки нужно писать команду снова и с новой строки.

Ошибки могут быть вызваны неправильным названием самого файла. Помните, что он называется «robots.txt». Используйте для названия нижний регистр, без вариаций типа «Robots.txt» или «ROBOTS.txt».

Поле User-agent должно быть заполнено всегда. Не оставляйте эту директиву без команды. Снова возвращаясь к хосту, помните, что если сайт использует протокол HTTP, то указывать в команде его не нужно. Только если это расширенный его вариант HTTPS. Нельзя оставлять директиву Disallow без значения. Если она вам не нужна, просто не указывайте её.

Выводы

Резюмируя, стоит сказать, что robots.txt – это стандарт, который требует точности. Если вы с ним ни разу не сталкивались, то на первых этапах создания у вас будет возникать много вопросов. Лучше отдать эту работу веб-мастерам, поскольку они работают с документом все время. К тому же могут случаться некоторые изменения в восприятии директив поисковыми системами. Если же у вас небольшой сайт - маленький интернет-магазин или блог - тогда достаточно будет изучить этот вопрос и взять один из универсальных примеров.