Наш высокотехнологичный век отличается своими широкими возможностями. С развитием электронных вычислительных машин перед людьми открылись удивительные горизонты. Любую интересующую новость теперь можно найти в глобальной сети совершенно бесплатно, не выходя из дома. Это прорыв в сфере техники. Но как же столько данных может храниться в памяти компьютера, обрабатываться и передаваться на далекие расстояния? Какие единицы измерения информации в информатике существуют? И как с ними работать? Сейчас не только люди, непосредственно занимающиеся написанием компьютерных программ, но и обычные школьники должны знать ответы на эти вопросы. Ведь это основа всего.

Определение информации в компьютерной науке

Мы привыкли считать, что информация – это все те знания, которые доносят до нас. Но в информатике и компьютерных науках это слово имеет немного другое определение. Это базовая составляющая всей науки об электронных вычислительных машинах. Почему базовая, или фундаментальная? Потому что компьютерная техника обрабатывает данные, сохраняет и доносит до людей. Минимальная единица измерения информации исчисляется в битах. Сведения хранятся в компьютере до тех пор, пока юзер не захочет просмотреть их.

Мы привыкли думать, что информация – единица языка. Да, это так, но в информатике используется другое определение. Это сведения о состоянии, свойствах и параметрах объектов окружающей нас среды. Совершенно ясно, что чем больше мы узнаем сведений об объекте или явлении, тем больше понимаем, что наше представление о них мизерное. Но теперь благодаря такому огромному объему совершенно бесплатных и доступных со всех точек планеты материалов стало гораздо проще обучаться, заводить новые знакомства, работать, отдыхать и просто расслабляться за чтением книг или просмотром кинофильмов.

Алфавитный аспект измерения объема информации

Печатая документы для работы, статьи на сайты и ведя свой личный блог в интернете, мы не задумываемся о том, как проходит обмен данными между пользователем и самой вычислительной машиной. Как машина способна понимать команды, в каком виде хранит все файлы? В информатике за единицу измерения информации принят бит, который может хранить двоичный код из ноликов и единиц. Суть алфавитного подхода в измерении текстовых символов заключается в последовательности знаков. Но не стоит переплетать алфавитный подход с содержанием текста. Это совершенно разные вещи. Объем таких данных пропорционален количеству введенных символов. Благодаря этому получается, что информационный вес знака из бинарного алфавита равен одному биту. Единицы измерения информации в информатике существуют разные, как и любые другие меры. Бит – это минимальная величина измерения.

Содержательный аспект высчитывания объема информации

Измерение информации базируется на основе теории вероятности. В данном случае рассматривается вопрос о том, какое количество данных содержится в получаемом человеком сообщении. Тут в ход идут теоремы дискретной математики. Для расчета меры объема материалов берутся две разные формулы в зависимости от вероятности события. При этом остаются прежними единицы измерения информации в информатике. Задачи расчета количества символов, графики по содержательному подходу гораздо сложнее, чем по алфавитному.

Виды информационных процессов

Существуют основные три типа процессов, осуществляемых в электронной вычислительной машине:

- Обработка информации. Как проходит данный процесс? Через инструменты ввода данных, будь то клавиатура, оптическая мышь, принтер или другие устройства, компьютер получает сведения. Затем конвертирует их в бинарный код и записывает на жесткий диск в битах, байтах, мегабайтах. Для перевода любой единицы измерения информации в информатике существует таблица, по которой можно высчитать, сколько в одном мегабайте бит, и осуществить другие переводы. Компьютер все делает автоматически.

- Хранение файлов и данных в памяти устройства. Компьютер способен запоминать все в бинарном виде. Двоичный код состоит из нулей и единиц.

- Еще один из основных процессов, происходящих в электронной вычислительной машине, – передача данных. Она тоже осуществляется в бинарном виде. Но на экран монитора информация выводится уже в символьном или другом привычном для нашего восприятия виде.

Кодирование информации и мера ее измерения

За единицу измерения информации принят бит, с которым достаточно легко работать, ведь он может вмещать значение 0 или 1. Как компьютер осуществляет кодирование обычных десятичных чисел в двоичный код? Рассмотрим небольшой пример, который объяснит принцип кодирования информации компьютерной техникой.

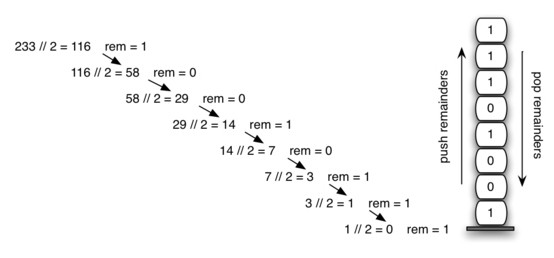

Допустим, у нас есть число в привычной системе исчисления – 233. Чтобы перевести его в бинарный вид, необходимо делить на 2 до того момента, пока оно не станет меньше самого делителя (в нашем случае – 2).

- Начинаем деление: 233/2=116. Остаток записываем отдельно, это и будут составляющие ответного бинарного кода. В нашем случае это 1.

- Вторым действием будет такое: 116/2=58. Остаток от деления – 0 – опять записываем отдельно.

- 58/2=29 без остатка. Не забываем записывать оставшийся 0, ведь, утеряв всего один элемент, вы получите уже совершенно другую величину. Этот код далее будет храниться на винчестере компьютера и являть собой биты – минимальные единицы измерения информации в информатике. 8-классники уже способны справиться с переводом чисел из десятичного типа исчисления в двоичный, и наоборот.

- 29/2=14 с остатком 1. Его и записываем отдельно к уже полученным двоичным цифрам.

- 14/2=7. Остаток от деления равен 0.

- Еще немного, и бинарный код будет готов. 7/2=3 с остатком 1, который и записываем в будущий ответ двоичного кода.

- 3/2=1 с остатком 1. Отсюда записываем в ответ две единицы. Одну – как остаток, другую – как последнее оставшееся число, которое уже не делится на 2.

Необходимо запомнить, что ответ записывается в обратном порядке. Первое получившееся бинарное число из первого действия будет последней цифрой, из второго – предпоследней, и так далее. Наш итоговый ответ – 11101001.

Такое бинарное число записывается в памяти компьютера и хранится в этом виде до тех пор, пока пользователь не захочет посмотреть на него с экрана монитора. Бит, байт, мегабайт, гигабайт – единицы измерения информации в информатике. Именно в таких величинах и хранятся бинарные данные в компьютере.

Обратный перевод числа из бинарной в десятичную систему

Для того чтобы осуществить обратный перевод из бинарной величины в десятичную систему исчисления, необходимо воспользоваться формулой. Считаем количество знаков в двоичной величине, начиная с 0. В нашем случае их 8, но если начинать отсчет с нуля, тогда они заканчиваются порядковым номером 7. Теперь необходимо каждую цифру из кода умножить на 2 в степени 7, 6, 5,…, 0.

1*27+1*26+1*25+0*24+1*23+0*22+0*21+1*20=233. Вот и наше начальное число, которое было взято еще до перевода в бинарный код.

Теперь вам известна суть кодирования информации компьютерным устройством и минимальная мера хранения информации.

Минимальная единица измерения информации: описание

Как уже упоминалось выше, наименьшей величиной измерения информации считается бит. Это слово английского происхождения, в переводе оно означает "двоичная цифра". Если посмотреть на данную величину с другой стороны, то можно сказать, что это ячейка памяти в электронных вычислительных машинах, которая хранится в виде 0 либо 1. Биты можно перевести в байты, мегабайты и еще большие величины информации. Электронная вычислительная машина сама занимается такой процедурой, когда сохраняет бинарный код в ячейки памяти винчестера.

Некоторые пользователи компьютера могут захотеть вручную и быстро перевести меры объема цифровой информации из одной в другую. Для таких целей были разработаны онлайн-калькуляторы, они сию же секунду осуществят операцию, на которую вручную можно было бы потратить много времени.

Единицы измерения информации в информатике: таблица величин

Компьютеры, флеш-накопители и другие устройства запоминания и обработки информации отличаются между собой объемом памяти, который обычно исчисляется в гигабайтах. Необходимо посмотреть на основную таблицу величин, чтобы увидеть сопоставимость одной единицы измерения информации в информатике в порядке возрастания со второй.

| Название величины объема информации | Степень перевода в минимальную величину | Символьное обозначение |

| Байт | 100 | б |

| Килобайт | 101 | Кб |

| Мегабайт | 102 | Мб |

| Гигабайт | 103 | Гб |

| Терабайт | 104 | Тб |

Использование максимальной единицы измерения информации

В наше время максимальную меру объема информации, которая называется йоттабайтом, планируют использовать в агентстве национальной безопасности в целях хранения всех аудио- и видеоматериалов, полученных из общественных мест, где установлены видеокамеры и микрофоны. На данный момент йоттабайты – наибольшие единицы измерения информации в информатике. Это предел? Вряд ли кто-то сможет дать сейчас точный ответ.