Понятие информационной энтропии подразумевает отрицательный логарифм функции массы вероятности для значения. Таким образом, когда источник данных имеет значение с меньшей вероятностью (т. е., когда происходит событие с низкой вероятностью), событие переносит больше «информации» («сюрприз»), чем, когда исходные данные имеют значение с более высокой вероятностью.

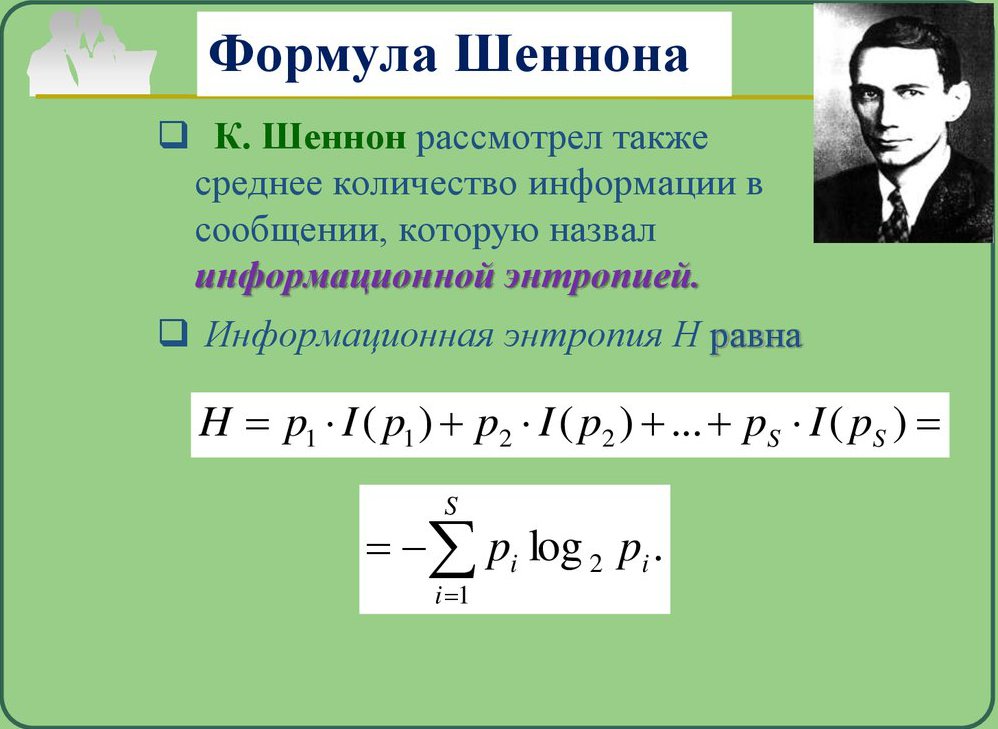

Объем информации, передаваемый каждым событием, определенным таким образом, становится случайной величиной, ожидаемым значением которой является информационная энтропия. Как правило, энтропия относится к беспорядку или неопределенности, а ее определение, используемое в теории информации, непосредственно аналогично определению, используемому в статистической термодинамике. Концепция ИЭ была введена Клодом Шенноном в его статье 1948 года «Математическая теория коммуникации». Отсюда и возник термин "информационная энтропия Шеннона".

Определение и система

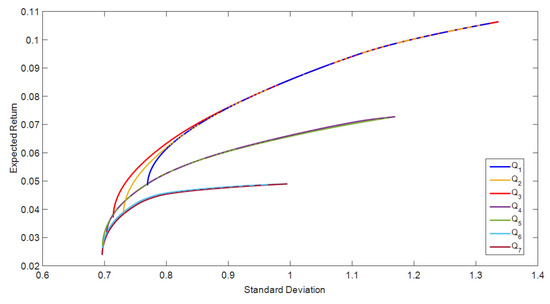

Базовая модель системы передачи данных состоит из трех элементов: источника данных, канала связи и приемника, и, как выражается Шеннон, «основная проблема связи» заключается в том, чтобы получатель мог идентифицировать, какие данные были сгенерированы источником, на основе сигнала, который он получает по каналу. Энтропия обеспечивает абсолютное ограничение на кратчайшую возможную среднюю длину кодирования без потерь сжатых данных по источнику. Если энтропия источника меньше пропускной способности канала связи, данные, генерируемые им, могут быть надежно переданы приемнику (по крайней мере теоретически, возможно, пренебрегая некоторыми практическими соображениями, такими как сложность системы, необходимой для передачи данных и количества времени, которое может потребоваться для передачи данных).

Информационная энтропия обычно измеряется в битах (альтернативно называемых «шэннонами») или иногда в «естественных единицах» (nats) или десятичных разрядах (называемых «dits», «bans» или «hartleys»). Единица измерения зависит от базы логарифма, которая используется для определения энтропии.

Свойства и логарифм

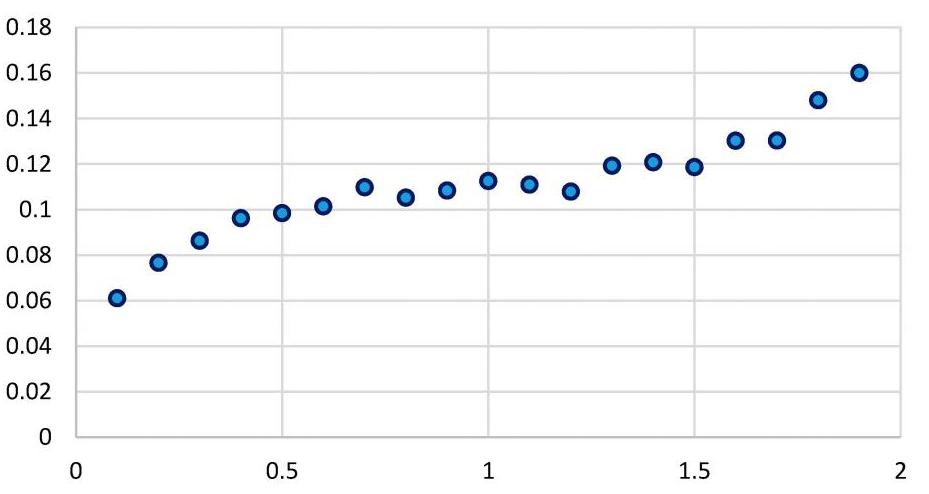

Логарифм распределения вероятностей полезен как мера энтропии, потому что он аддитивен для независимых источников. Например, энтропия справедливой ставки монеты составляет 1 бит, а энтропия m-томов - это m бит. В простом представлении биты log2 (n) необходимы для представления переменной, которая может принимать одно из n значений, если n является степенью 2. Если эти значения одинаково вероятны, энтропия (в битах) равна этому числу. Если одно из значений более вероятно, чем другие, наблюдение, что это значение происходит, менее информативно, чем если бы произошел какой-то менее общий результат. И наоборот, более редкие события предоставляют дополнительную информацию при слежении.

Поскольку наблюдение менее вероятных событий происходит реже, нет ничего общего, что энтропия (считающаяся средней информацией), полученная из неравномерно распределенных данных, всегда меньше или равна log2 (n). Энтропия равна нулю, когда один результат определен.

Информационная энтропия Шеннона количественно определяет эти соображения, когда известно распределение вероятностей исходных данных. Смысл наблюдаемых событий (смысл сообщений) не имеет значения в определении энтропии. Последняя учитывает только вероятность наблюдения определенного события, поэтому информация, которую оно инкапсулирует, представляет собой данные о лежащих в основе распределения возможностях, а не о значении самих событий. Свойства информационной энтропии при этом остаются теми же, что описывались выше.

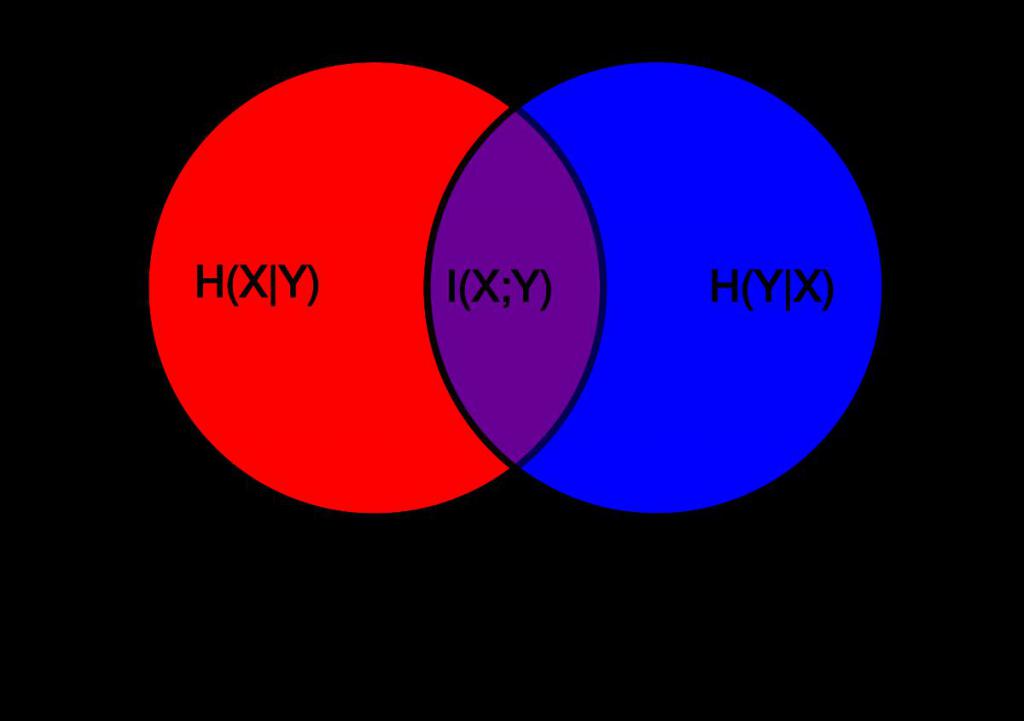

Теория информации

Основная идея теории информации заключается в том, что чем больше человек знает о теме, тем меньше информации о ней можно получить. Если событие очень вероятно, это не удивительно, когда это происходит и, следовательно, дает мало новой информации. И наоборот, если событие было невероятным, гораздо более информативным было то, что произошло событие. Следовательно, информационное наполнение является возрастающей функцией обратного вероятности события (1 / p).

Теперь, если произойдет больше событий, энтропия измеряет средний информационный контент, который вы можете ожидать, если произойдет одно из событий. Это означает, что литье штампа имеет больше энтропии, чем бросание монеты, потому что каждый результат кристалла имеет меньшую вероятность, чем каждый результат монеты.

Особенности

Таким образом, энтропия является мерой непредсказуемости состояния или, что тоже самое, его среднего информационного содержания. Чтобы получить интуитивное понимание этих терминов, рассмотрите пример политического опроса. Обычно такие опросы случаются, потому что результаты, например, выборов еще не известны.

Другими словами, результаты опроса относительно непредсказуемы, и на самом деле его проведение и изучение данных дают некоторую новую информацию; это просто разные способы сказать, что априорная энтропия результатов опроса велика.

Теперь рассмотрим случай, когда один и тот же опрос выполняется второй раз вскоре после первого. Поскольку результат первого опроса уже известен, показатели второго опроса могут быть хорошо предсказаны, и результаты не должны содержать много новой информации; в этом случае априорная энтропия второго результата опроса мала по сравнению с первой.

Бросок монеты

Теперь рассмотрим пример броска монеты. Предполагая, что вероятность решки совпадает с вероятностью орла, энтропия броска монеты имеет очень высокое значение, поскольку является своеобразным примером информационной энтропии системы.

Это связано с тем, что невозможно предсказать, что исход монеты забрасывается досрочно: если нам нужно будет выбирать, самое лучшее, что мы можем сделать, - это предсказать, что монета упадет решкой, и это предсказание будет правильным с вероятностью 1 / 2. Такой бросок монеты имеет один бит энтропии, так как есть два возможных результата, которые происходят с равной вероятностью, а изучение фактического результата содержит один бит информации.

Напротив, бросок монеты, использующей обе стороны с решками и без орлов, имеет нулевую энтропию, так как монета всегда упадет на этот знак, и результат можно предсказать отлично.

Заключение

Если схема сжатия не имеет потерь, то есть вы всегда можете восстановить все исходное сообщение, распаковывая, тогда сжатое сообщение имеет такое же количество информации, что и оригинал, но передается меньшим количеством символов. То есть он имеет больше информации или более высокую энтропию на каждый символ. Это означает, что сжатое сообщение имеет меньшую избыточность.

Грубо говоря, теорема о кодировании исходного кода Шеннона гласит: схема сжатия без потерь не может сокращать сообщения в среднем, чтобы иметь более одного бита информации на бит сообщения, но может быть достигнуто любое значение, меньшее одного бита информации на бит сообщения, используя подходящую схему кодирования. Энтропия сообщения в битах, умноженная на его длину, является мерой того, сколько общей информации содержится в нем.